🗣 SL提问: ai模型部署

✍️ Ai批改: AI模型部署是将训练好的机器学习或深度学习模型集成到生产环境中的过程,使其能够处理实际任务并提供预测或决策服务。以下是AI模型部署的关键步骤、方法和注意事项:

1、部署流程

1、模型准备

格式转换:将训练好的模型转换为部署友好的格式(如TensorFlow的SavedModel、PyTorch的TorchScript、ONNX等)。

轻量化:通过剪枝(Pruning)、量化(Quantization)或蒸馏(Distillation)减小模型体积,提升推理速度。

依赖检查:确保目标环境支持模型所需的框架(如TensorFlow、PyTorch)和硬件(GPU/TPU)。

2、选择部署方式

本地部署:模型运行在本地服务器或设备(如边缘设备、移动端)。

云部署:利用云服务(AWS SageMaker、Google Vertex AI、Azure ML)托管模型,提供API服务。

边缘部署:在IoT设备或终端(如手机、摄像头)上直接运行模型,减少延迟(如TensorFlow Lite、Core ML)。

3、构建服务接口

REST API:使用Flask、FastAPI或Django将模型封装为HTTP服务。

gRPC:高性能RPC框架,适合低延迟场景。

批处理:对离线数据批量推理(如Apache Spark或Airflow流水线)。

4、监控与维护

性能监控:跟踪延迟、吞吐量、错误率(Prometheus/Grafana)。

模型更新:支持热更新(Blue-Green部署、Canary发布)。

数据漂移检测:监控输入数据分布变化,触发模型重训练。

2、常用工具与平台

云服务:

AWS SageMaker、Google Vertex AI、Azure Machine Learning

阿里云PAI、华为云ModelArts

开源框架:

服务化:FastAPI、Flask、TensorFlow Serving、TorchServe

边缘计算:TensorFlow Lite、ONNX Runtime、PyTorch Mobile

容器化:Docker + Kubernetes(用于大规模弹性部署)

3、优化策略

硬件加速:

使用GPU/TPU加速推理(NVIDIA Triton Inference Server)。

针对移动端优化(ARM NEON指令集、苹果Core ML)。

缓存与批处理:

缓存频繁请求的预测结果。

合并请求批量推理(如NVIDIA TensorRT的动态批处理)。

4、挑战与解决方案

延迟与吞吐量:

优化模型结构(如使用EfficientNet替代ResNet)。

水平扩展(多实例负载均衡)。

安全性:

输入数据验证(防对抗攻击)。

模型加密(如Intel SGX可信执行环境)。

成本控制:

按需扩展(Serverless无服务架构)。

混合部署(冷热模型分层)。

5、典型场景示例

实时推荐系统:

部署为微服务,通过Kafka接收用户行为数据,实时返回推荐结果。

医疗影像分析:

模型部署在边缘设备(如CT机),本地处理敏感数据。

自动驾驶:

模型运行在车载芯片(NVIDIA Jetson),低延迟处理传感器数据。

总结

AI模型部署需平衡性能、成本、可维护性,选择适合业务场景的方案。对于初创团队,可优先使用云服务快速上线;对高隐私需求场景,边缘部署或私有化方案更合适。持续监控和迭代是保证模型长期有效的关键。

0

IP地址: 61.61.126.191

搜索次数: 51

提问时间: 2025-04-24 00:38:20

❓️ 热门提问:

外贸建站得多少钱

国内黄金回收价走势图

人工智能ai展望

100年金价走势

杭州ai线下培训

四字母域名注册

全球外汇日交易量

杭州ai学习班

1000元金手链

摩根共同分类目录绿色债券A

豌豆Ai站群搜索引擎系统

🤝 关于我们:

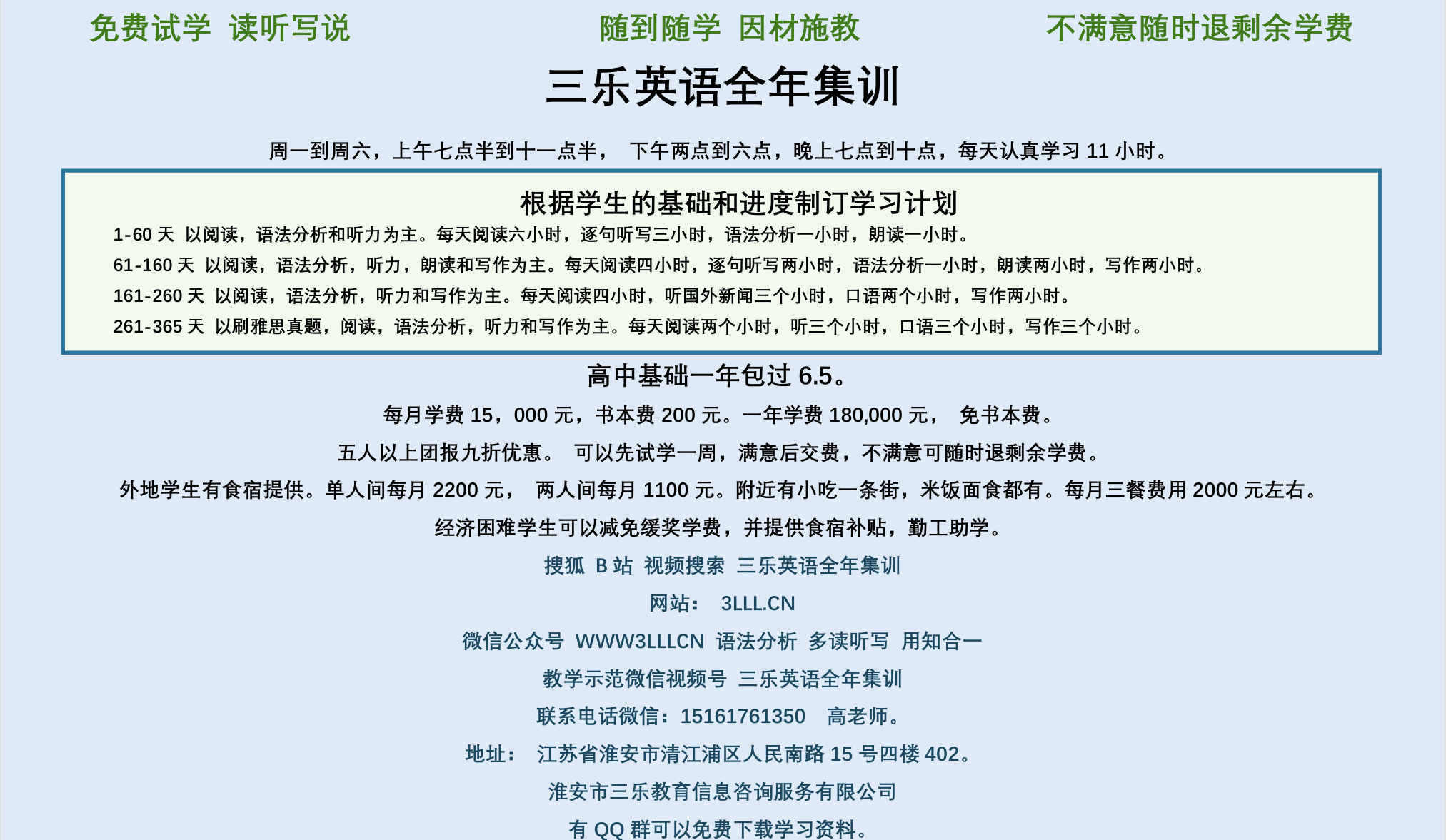

三乐Ai

作文批改

英语分析

在线翻译

拍照识图

Ai提问

英语培训

本站流量

联系我们

📢 温馨提示:本站所有问答由Ai自动创作,内容仅供参考,若有误差请用“联系”里面信息通知我们人工修改或删除。

👉 技术支持:本站由豌豆Ai提供技术支持,使用的最新版:《豌豆Ai站群搜索引擎系统 V.25.05.20》搭建本站。